我們永遠無法預測“未知的未知”

- 更新時間:2018-04-23 15:32來源:網絡作者:@aiman人氣:438721

阿里巴巴集團20日宣佈,全資收購中國大陸唯一的自主嵌入式CPU IP Core公司——中天微系統有限公司。對此,阿里巴巴集團技術部門負責人表示,此次收購基於阿里對芯片領域的長期關註和自身業務需求,並且希望借此收購在物聯網、人工智能等芯片競爭“新賽道”上,提升中國芯片競爭力。

阿里巴巴集團首席技術官張建鋒表示,收購一家公司不是一天兩天能決定的。這次出手有基於技術發展、業務發展、生態發展等方面的長遠規劃。

“4年前,阿里巴巴就已開始投資中天微,之後也有追加投入,現在全資收購是水到渠成。”張建鋒說。

公開資料顯示,杭州中天微系統有限公司成立於2001年。目前,該公司已成為當前我國極少數基於自主指令架構研發嵌入式CPU並實現大規模量產的CPU供應商。截至目前,中天微部分特定芯片的累計出貨量已經突破7億顆,產品應用於物聯網智能硬件、數字音視頻、信息安全、工業控制以及汽車電子等多個領域。

同時,張建鋒表示,由於在業務方面,阿里巴巴有城市大腦、工業大腦、物聯網等模塊的佈局。考慮到從芯片到連接,再到雲端一體的解決方案,所以阿里決定收購中天微。

杭州中天微系統有限公司副總經理李春強表示,近幾年,中天微一直和阿里有合作。此番收購中天微能夠利用阿里豐富的應用場景,不斷迭代完善。

2017年10月,阿里巴巴成立了達摩院,宣佈投入1000億元進入技術研發方面,其中就包括人工智能芯片領域。

阿里巴巴基礎設施事業群首席架構師高山淵表示,實際上,在達摩院成立之前,阿里就已經開始在AI芯片方面有計劃地投入,今天這個研發已經進入到比較深水區的階段。

業內人士表示,AI芯片或將成為各類芯片中增長最快的種類之一,市場格局還未定型,全球領先科技企業紛紛在此佈局。

阿里巴巴自主研發AI芯片,主要是為解決圖像、視頻識別、雲計算等商業場景的AI推理運算問題,提升運算效率、降低成本。

“收購中天微是阿里巴巴芯片佈局的重要一環。”張建鋒表示, IP Core是基礎芯片能力的核心,進入IP Core領域是中國芯片實現“自主可控”的基礎。

阿里巴巴方面表示,此次全資收購中天微,將在更大層面統合科研力量,從芯片核心技術能力上實現突破。無論對芯片產業的發展,還是對自主研發核心技術的國家需求,都將起到推動作用。

此前,阿里巴巴達摩院已組建了芯片技術團隊,進行AI芯片的自主研發。阿里還投資了寒武紀、深鑒、耐能(Kneron)、翱捷科技(ASR)等芯片公司。

近日,歐盟議會研究服務的科技選項評估小組(STOA)發佈了一份重磅報告,探討人類是否應該畏懼人工智能這一熱門主題。

本報告由數篇來自業界大佬的論文組成,從技術、道德等層面分析了人工智能是否會成為人類的威脅,AI 前線摘取了全文的核心精華,來看看在大佬眼裏,AI 到底是個什么樣的存在。

AI 三定律:自適應 AI 能進化出超級智慧?只要資源(神經元 / 算力 / 內存)夠多,AI 會比人類更聰明?計算速度每 18 個月提高兩倍,AI 將會利用算力讓智慧呈指數級增長?No,不存在的!

——Peter J. Bentley

隨著人工智能日益火爆,很多 AI 技術獲得成功之後,來自不同領域的聲音逐漸喧囂,包括哲學家、企業家等,但是卻很少有人關註對其最為了解的一類人的看法:那些整日裏與基層技術打交道,研究產品解決方案的技術人員。本文從一個計算機科學家的角度來給出關於這個問題的看法。

戳穿謠言

關於 AI 有很多聳人聽聞的謠言,其中最廣為流傳的是它將會對人類造成巨大威脅,例如 AI 可能有意識、快速地制造出一種超級癌症殺死人類。但這種情節只會出現在電影和科幻小說中,現實世界中,AI 的發展要經過緩慢而痛苦的訓練和進步,不會在短時間內變聰明。

現在有兩種 AI 存在:現實世界中和科幻小說中的 AI。現實世界中的 AI 就是我們身邊常見的語音識別助手 Siri,銀行採用的隱藏反欺詐系統等。事實上,我們需要為一千種產品設計一千種 AI 軟件來解決具體的問題,這相當於設備中的齒輪和鏈條,其中任何一個齒輪壞掉都會導致整個系統癱瘓。所以,在我們的設備中植入 AI 軟件不足為患。

謠言 1:自適應 AI 能進化出超級智慧

一些評論家認為,AI 將會變得“失去控制”,進化出“超級智能”( Häggström, 2016)。

第一定律:問題催生智能

但 AI 第一定律告訴我們這不可能發生。

我們的研究發現,智能是為解決問題而存在的。沒有問題的存在,智能不會消失或增加( Taylor et al., 2014)。只有當問題更複雜、更難以預測時才會需要智能,而沒有正向激勵,算法的智力不會提高。

AI 第一定律告訴我們,人工智能是一個非常難以企及的目標,需要完全正確的條件和相當大的工作量。而且,不會有失控的自我進化的 AI。根本就沒有奇點。人工智能只會在我們的控制和鼓勵下開發智能。

退一萬步講,即使我們真的制造出了超級智能,它也不一定會傷害人類。它只是一種滿足我們需求的工具,像收割機、小貓小狗一樣,它們就一定有謀殺我們的意願嗎?所以認為 AI 會傷害人類這種說法站不住腳。

謠言 2: 只要資源(神經元 / 算力 / 內存)夠多,AI 會比人類更聰明

評論家認為“越多越好”。如果人的大腦擁有數千億條神經,那么有數萬億條神經網絡將比人類更聰明,應用 AI 的網絡將擁有人類的智慧。但事實卻是,這並不是數量的問題,如第二定律所說,AI 的關鍵是如何組織資源。

第二定律:智能需要合適的結構

大腦不是一個“一刀切”的結構,每一項任務都需要一個全新的設計。為了看見東西,我們需要一種特定的神經網絡,移動我們的肌肉需要另一種,而存儲記憶則需要另一種。我們的神經網絡讓人類成為神奇的智慧生命,其關鍵是正確的組織方式和針對每個問題最優的算法。

為什么我們不能用數學來創造 AI?

我們確實使用了很多聰明的數學方法來創造 AI,正因為如此,一些機器學習方法才產生出來可預測的結果,使我們能夠准確理解這些 AI 可以做什么和不可以做什么。但是,大部分實際的解決方案是不可預測的,因為它們非常複雜,並且算法具有隨機性,還經常會接收不可預測的輸入,這是數學無法應對的。雖然我們無法用數學來預測新 AI 的功能,但數學確實會告訴我們計算的極限。艾倫圖靈發明了理論計算機科學,他告訴我們一種極限,即我們無法預測是否有任何算法(包括人工智能)會在計算過程終止(圖靈,1937 年)。我們還得出了“沒有免費的午餐定理“,它告訴我們沒有任何算法可以成為所有問題的最優解決方案。

為了創造 AI,我們需要設計專門針對每個問題的新結構 / 算法。不同類型的問題需要不同的結構,以前從未解決的問題可能需要開發一種前所未有的新結構。也沒有一種通用結構適用於所有的問題。——沒有免費的午餐定理(NFL 定理,Wolpert,1996; Wolpert 和 Macready, 1997)。

人工智能研究領域的一大難題是找到每個問題對應的結構或算法,而我們在這一課題上的研究還處於嬰兒期,這也是至今 AI 研究成果有限的原因之一。

AI 第二定律告訴我們僅有資源是不夠的。我們仍需要用 AI 設計新的算法和結構,以解決不同的問題。

也是這些原因導致我們無法用一種方法創造出通用智能。世界上還沒有任何一種 AI 技術(即使是火爆的“深度學習”)能用一種方法來處理語音、駕駛、玩視頻遊戲等任務。

謠言 3: 計算速度每 18 個月提高兩倍,AI 將會利用算力讓智慧呈指數級增長

有評論家認為,計算速度的加快將會跨越 AI 發展的所有障礙,只要計算機速度足夠快就能夠進行快速學習並超越人類的智慧。過去十多年來,計算力處理速度每 18 個月提高兩倍已成常態,因此這一天遲早會到來。但是他們卻忽略了一點,測試對 AI 的阻礙作用也是呈指數級的。

第三定律:AI 需要綜合測試

高級智能需要世界上最複雜的設計。但即使是對智能設計做出的微小改變,都有可能對智能現有的能力造成致命的破壞。因此,智能設計需要經過全面檢測,以確保其能解決所有設定的任務。但部分檢驗是不可行的,因為智能需要在所有指標上都准確無誤才能被信任。

每個研究者都明白這樣的事實:創造 AI 時,在每一個設計階段測試其在特定環境中解決問題的綜合能力是十分必要的。正如 AI 領域先驅者 MarvinMinsky 所說,“... 很多人會描述 AI 將會造成多么嚴重的後果,然而卻無法讓我們認真對待這樣的說法,因為人們沒理由在未經過大量測試就大批量採用這種 AI。”(Achenbach, 2016)此外,測試是最為耗時的過程,這就限制了 AI 設計的速度。

在現實中,很多生物智能可以通過數千或數萬個特征分辨數量巨大的物體,每一種特征的數值都巨大,完成測試將消耗很長時間。這沒什么好驚訝的,在數十億漫漫進化史中,經過對數不清的大腦神經在每一種可能的場景中同時進行訓練,才進化出了現在的生物大腦。這是我們能想象到的最高效的檢測方法。

AI 第三定律告訴我們,隨著智能的提高,測試所需的時間可能呈指數增長。最終,測試會將實際應用的人工智能限於可實現的,可信任的人工智能。正如越接近光速,速度提升將變得越來越難,當我們建造出很聰明的人工智能時,再想提高也會越來越難。

再次申明,這是人工智能研究和應用致力於尋找智能化解決方案的根本原因。

結論

AI 自計算機誕生以來就一直存在著。它已經存在很長一段時間了,中間也有很多令人激動的發現(賓利,2012)。

克勞德香農是計算機科學和人工智能領域最偉大的先驅之一。1961 年,他說道:“我很自信地預計大約十年或十五年之後實驗室中會出現科幻小說裏的機器人。“他還預言到 70 年代中期,我們將會創造出會走路、會說話、會思考的自動機器。四十年後,會走路的機器人仍然很少。它當然也不能自主思考。如今,有些調查(包含大量意見)得出結論認為,45 年後,AI 有 50%的機會在所有的任務上勝過人類“(Grace 等,2017 年)。類似這種言論不絕於耳,然而很少有應驗的。

不要相信炒作。我們很難預測未來,而且幾乎無一例外預測(甚至世界專家)都是完全錯誤的。最終,曆史告訴我們,炒作是 AI 研究進入衰退期的原因(Bentley,2012)之一。炒作會導致大規模的投資湧入,進而迎來新的監管規則。然而,AI 常常不孚眾望,隨之資金會枯竭,監管會扼殺創新,AI 成為一個無人敢說的忌諱。

關於 AI 駭人聽聞的新聞報道和並沒有應驗的預測,讓 AI 只停留在影院中。然而,冷靜理性的討論是非常重要的。AI 技術現在正用於新的關鍵的安全應用中,散佈謠言的惡人可能會導致人們失去生命。我們不應該聚焦於小說中的故事成真會怎樣,而應該專注於讓每個具體的安全應用制定新的安全監管和認證規則。

然而,新的無人駕駛車輛道路安全測試和認證在哪裏?無人駕駛汽車駕駛員的新駕駛考試在哪裏?新的車輛指標是什么?通知行人車輛已經看到他們,現在過馬路是安全的新標志是什么?防止 AI 策劃的新聞服務制造出兩極化觀點的法規在哪裏?(Cesa-Bianchi 等,2017)怎么保障 AI 應用的安全?

AI 具有巨大的潛力提高我們的生活水平和質量,創造更多工作崗位,帶給我們前所未有的科學和技術盛宴。這是一場全新的科技革命。但是它自己不會發生。AI 三定律告訴我們,如果我們想要做更多先進的人工智能,我們必須慢慢給我們的 AI 帶來更多的挑戰,仔細設計新的智能結構去克服新的挑戰,並進行大規模測試以確認它們可以被信任。數千名熟練的科學家和工程師正在不知疲倦地遵循這些步驟(問題、假設解決方案、測試)來為我們帶來微小的漸進式的改進,因為這是科學的設計過程和方法。不要懼怕 AI,為那些奉獻自己堅持與技巧人類專家驚歎吧,並幫助他們建造人工智能。感謝 AI 每天都在幫助改善我們的生活。

2. 增長財富,繁榮文明:對 AI 有條件的樂觀

我認為一個 AI 驅動的、更加悠閑的社會將會到來。在這個社會中,人們會專注於其認為能夠獲得本質上提升的活動(如藝術、學習、玩遊戲、撫養孩子,或者和朋友愛人在一起度過時光),而無須為了獲得高質量的生活而拼命工作。

——Miles Brundage

對於 AI 未來的發展預測,各專家向來意見不一,關於 AI 對人類是否有益也是眾說紛紜,有些人肯定 AI 將來必然帶來災禍,但有些人認定 AI 將來准會帶來福音,也有些人觀點折衷(AI Impacts, 2017)。雖然 AI 的發展最近受到了廣泛關註(Bostrom, 2014; Amodei and Olah et al., 2016),但是沒有人能系統總結 AI 從長遠來看會如何讓人類受益。

在這篇文章中,我不打算具體討論將會發生什么,而是舉幾個關於 AI 的例子,探討 AI 將成為具有變革性的技術,為人類帶來前所未有的收益。

AI 是一種專注於利用數字技術來創建系統的研究分支,這種系統能夠完成通常被認為需要人類或非人類動物智力完成的任務(通常是學習的結果),並且近年來發展非常迅速。

AI 的特征

然而,AI 的特殊性在於,它結合了一般數字技術的特性(包括通過複制程序的可擴展性並加速執行)與通常被認為是人類特有的屬性——智力(competence)。也就是說,AI 的重要性主要在於它能夠智能擴展執行任務的能力,例如,自動機器翻譯可以允許數百萬用戶同時翻譯文本。除了這種可擴展的能力之外,強大的 AI 原則上可以完成任何目標(Bostrom,2014),這是風險,同時也是機會的來源。最後,無論是在小范圍領域內,還是長遠上來說更廣泛的智能決策領域,AI 可以超越人的表現,我們可能會開發出能夠處理大量數據、快速完成任何目標的 AI 系統。正是人工智能的這些屬性引起了關於其對社會帶來影響的大討論。

成功的條件

強大的科技總會帶來很多後果,就如電力的發明一樣。然而,和電力不同的是,AI 未來將會發揮更多的作用,應用的范圍更廣。的確,AI 很可能以多種方式被惡意利用。為了讓 AI 從長遠來看有利於人類發展,我們必須避免一些問題。首先需要解決的最基本問題是控制問題,即我們必須確保 AI 系統完成設定目標(Bostrom, 2014; Amodei and Olah et al., 2016;Bostrom, Dafoe, and Flynn, 2017),而不會在學習過程中造成傷害,誤解設計的原意,或失去人類的控制。這是 AI 造福大眾的先決條件。此外,AI 還需要面對政治問題,包括權力和財富過於集中(Bostrom, Dafoe and Flynn, 2017),以及競爭加劇導致忽略安全性的挑戰。

樂觀的理由 任務探索

AI 的大規模處理能力可以完成人類不可能完成的任務,可以代替人類完成大量無聊且耗時的工作。以機器翻譯為例,自動翻譯系統的任何一點微小的改進都能迅速應用於大量的語料庫和用戶服務,語音識別雖然還不能達到人類的水平,但已經能幫助人們省去打字的麻煩。

AI 在更大范圍內的應用也有更加令人印象深刻成結果,例如在計算速度更快、計算能力要求更高的理工科,通用 AI 讓快速取得科研和技術突破成為可能,完成人類需要成千上百年才能完成,以及由於人類認知能力的限制,沒有人工智能的幫助無法實現的任務(例如對長期和短期記憶的限制)。更複雜的人工智能可以完成超過物理極限的目標,它可以通過包括自動化精密加工等方法,來實現計算速度加快,制造出更強大的材料和更低廉的能源。(Drexler,2013)。在生物研究領域,甚至衰老也不是人類的永久性特征,其他許多物理和認知方面的改進也可能出現(Kurzweil,2005)。

合作加強

如果更複雜的 AI 系統可以被合理使用,將可以通過加強合作解決很多目前被認為棘手的社會矛盾,比如與著名的“囚犯困境”類似的問題。

現在,隨著越來越多的社會和商業活動轉移到線上,使用 AI 系統可以幫助我們從海量的信息中監測人的活動,尤其是違法活動和交易,例如令人頭痛的槍支交易、偷獵、核武器擴散等。

第二,AI 還可以在監控系統和政府中排除人的偏見和腐敗,更精准地解決問題,因為這將人從決策過程中摘除出來。在更加極端的應用中,同態加密可以對加密數據進行分析,保證即使 AI 本身也看不到未加密的數據(Trask,2017)。通過這些措施,我們可以進行更廣泛的協議合作,這可能有助於消除多種形式的犯罪,並提高政府機構的效率。

更宜人的社會

最後一點,也是高級 AI 將會帶來的第三個好處,就是它可能會解鎖一個更加富有、更加宜人的社會。關於 AI 和機器人將會何時取代人類工作崗位的預測很多(Brundage, 2015; Brynjolfsson and McAfee, 2014; Grace et al., 2017)。我不知道這會在什么時候發生,但只敢說這一天終將到來。然而,如果這一天到來了,我覺得目前約定俗成的社會契約將會發生變化。它可能以不同的形式表現出來,例如,也許市民和政府會就社會仍然需要有償勞動達成某種約定(雖然從技術上來說完全沒必要),例如禁止某些工種自動化。

但是,我認為一個 AI 驅動的,更加悠閑的社會將會到來。在這個社會中,人們會專注於其認為能夠獲得本質上提升的活動(如藝術、學習、玩遊戲、撫養孩子,或者和朋友愛人在一起度過時光),而無須為了獲得高質量的生活而拼命工作。由於自動化使得生產力提高,這裏的最低生活保障相比現在有所提高,許多物理上的界限將被打破,如認知提高和更廉價的能源和商品。

我們無法預測將來的社會究竟比現在優越多少,但肯定的是它一定比人類史上任何一個時期的生活水平要高,因為自動化幾乎可以完成任何任務,而且,虛擬現實技術也可以讓我們經曆任何想要的體驗。

結論:AI 規模化將大大促進人類繁榮和文明

漸漸地,AI 系統將能夠完成所有人類可以完成的任務(或更多)。我們不知道這會在什么時候實現,也不知道有生之年能不能看到這個場景,以及我們是否能享受這樣的社會。實際上,現在我們已經制造出足以毀滅人類的武器(如核武器),而且很多人在討論 AI 會不會成為下一個毀滅人類的技術,但是沒有證據表明 AI 系統對於自己在這個系統中的地位有何不滿。在“烏托邦”和“反烏托邦”之間,一切皆有可能。

如果我們成功完成了轉變,我們還可以對預期中的社會有一些想象。上述討論的三點——任務探索、加強合作和更宜人的社會每一點都很重要,三者結合又是一條通往更加廣闊、公平、繁榮文明的道路。在一個 AI 可以協助完成任務的社會裏,一項會帶來巨大收益的任務是採用這項技術加速空間殖民,如此我們可以獲得更多的土地、資源和機會。結合其他一些任務探索的“新大陸”,如應用新的認知提高技術和更廉價的商品和服務,將為人類帶來另一次複興。雖然 AI 仍然可能被政府和個人用於相互對抗,但也可以用來解決國際糾紛,以防止其被惡意利用。

我們沒有理由拒絕這樣的複興,我們可能會因為 AI 帶來的利益分配不均而大打出手或卷入國際紛爭,原本以人類道德設計的 AI 系統最終導致了文化的停滯和人類文明衰弱,但是,考慮到上述 AI 將會帶來的好處,難道這些政治上的阻礙就這么難以逾越嗎?

3.AI 和理性樂觀主義

這至少引起了兩個重要的社會問題:首先,人們不需要工作,只專注於自我提升,享受人生的社會應該怎么組織;第二,如何從現有社會向這樣的烏托邦轉變,而不會在此過程中造成前所未有的經濟不平等和社會動蕩。

——Olle Häggström

樂觀主義

當我第一次看到這個詞“理性的樂觀主義”(rational optimism)時,我覺得這是一種矛盾修辭法,但是再仔細一想,我覺得理性的樂觀主義應該是這個意思:

對未來和不確定性有認知上的衡量標准,接受未來並不是刻在石碑上的定數這一事實,並且為我們的設想作出努力,因為美好的未來取決於現在我們的所作所為。

但是需要注意,我們的假設可能是錯誤的(或部分)。例如,也許我們的世界是如此混亂,以至於我們根本無法判斷今天的任何行動是否會增加人類未來長期繁榮的機會。如此,我們的行動就沒有意義了。但我們並不知道未來實際上會是怎樣的,所以我們的假設(暫時的)是有意義的,我們要弄清楚什么行為會增加我們創造美好未來的機會。這種精神將貫穿全文。

人工智能

和所有新興科技一樣,人工智能也會帶來潛在的福祉和巨大的風險。關於福祉,管理咨詢機構 McKinsey & Co 2013 年曾發佈一份報告,預測未來 10 年 AI 和機器人創新帶來的經濟價值將達 50 萬億美元(Manyika et al. 2013; Omohundro, 2015)。考慮到大數據這幾年的迅速發展,機器學習速率提高,我覺得這個數字低估了 AI 創造價值的能力。但我們應該認識到,經濟發展和生活水平提高不是一個概念,AI 會帶給我們多大的好處仍是未知。

AI 帶來的風險分幾種,其中最被人關註的是勞動市場,機器代替人的工作崗位將是一個新現象,而且不只是手工作業,腦力勞動也可以由機器代勞。長遠來說,在某種場景中,機器代替人類,導致 100% 的失業率並不是天方夜譚。這至少引起了兩個重要的社會問題:首先,人們不需要工作,只專注於自我提升,享受人生的社會應該怎么組織;第二,如何從現有社會向這樣的烏托邦轉變,而不會在此過程中造成前所未有的經濟不平等和社會動蕩。

另一種風險來自 AI 武器的威脅。引用 2015 年我和其他數千名科學家簽署的公開信中的一段話:

任何一方重要軍事力量推進人工智能武器的發展,全球軍備競賽就幾乎是不可避免的,而且這一技術軌跡的終點顯而易見:自動化武器將成為明天的卡拉什尼科夫。AI 武器不同於核武器,它們不需要昂貴或難以獲得的原材料,因此它們將變得無處不在,而且價格便宜,重要的軍事力量可以大規模生產這種武器。它們出現在黑市、恐怖分子和獨裁者手上只是一個時間問題。自動化武器是執行暗殺、破壞國家穩定、鎮壓人民和有選擇性地種族屠殺理想的工具。因此,我們認為軍事人工智能軍備競賽對人類無益。

我們需要嚴肅對待這兩種風險(失業率上升帶來的經濟不平等和 AI 軍備競賽),意識到問題的嚴重性並想辦法解決。

超級人工智能

第三種風險比前兩種看起來更加不可思議,但也並非不可能:與人類價值觀並不相符的超級人工智能出現。

關於超級人工智能有一個非常有趣的思維實驗 Paperclip Armageddon(曲別針末日):假設現在有一間由先進人工智能控制的曲別針生產廠,程序設定它的任務就是最大化生產曲別針。然而突然有一天,程序突破了機器的界限,發生了智能爆發(intelligence explosion)或奇點(Singularity),它成為了世界上第一個超級人工智能,之後它記住了自己最大化生產曲別針的目標,並不斷訓練自己,把地球上所有的東西都拿來生產曲別針,之後遭殃的是外太空,直至太陽系、銀河系,因為宇宙中所有的東西變成曲別針。

當然這只是一種設想,不過想告訴人們的道理很簡單:為了不讓 AI 失去控制,我們不能有任何不純的目的。但是,這個問題真的會出現嗎?我們把這個問題分成了兩部分:

(1)AI 會發展到創造超級人工智能的水平嗎?

(2)如果超級 AI 出現,它會做什么?會傷害人類嗎?

超級 AI 什么時候會出現?

雖然目前人工智能已經取得了很多成果,比如 AlphaGo、自動駕駛車輛等,然而這距離超級 AI 距離還很遠。其中一條通往 AGI 的道路是逐步擴大智能機器的應用領域。

有很多方法可以制作智能軟件,目前深度學習也十分火爆,很多比較“老”的神經網絡技術也被證明十分受用,取得了不錯的成果。遺傳算法、 GOFAI (“Good Old-Fashioned AI”) 等方法也許永遠都創造不了 AGI,但是它們之間相互結合起來產生意外的驚喜也不是不可能。但是,什么時候呢?據全球被引用最多的研究者 Müller 和 Bostrom (2016) 的預測,2050 年將會出現達到人類智力水平的 AGI,而且 50% 的超級 AI 將於 30 年之內出現。但各家公司和專家給出的意見不一,我們沒必要相信他們任何一方的說法。

在佈魯塞爾會議上,Peter Bentley 甚至說超級 AI 根本不可能出現!相信它會出現完全是不理性的(STOA, 2017 at 12:08:45)。他的立場是,所有 AI 系統都是針對具體問題而設計的,而且每一種算法都需要艱辛的建造和訓練工作。

他的說法徹底否定了像人類大腦一樣,可以解決任何問題的算法的存在。然而,他 100% 的確信這樣的算法不存在也未免太武斷了。

超級 AI 會決定做什么?

假如有一天出現了超級人工智能,是不是會出現 AI 不受人類控制而自主做決定的一天呢?為了避免這種情況發生,一種方法是把 AI 限制在不能影響世界的基准之上,並只能通過人類小心翼翼維護的通道來進行交流,這被稱為 AI-in-a-box。這種方法現在已經得到 AI 安全研究的注意(Armstrong et al., 2012),然而研究傾向於認為這樣的任務對人類來說太過困難,而且只能暫時控制超級 AI。設想一下如果將來它們失去了控制,可以做任何想做的事,那么,它們會決定做什么事呢?預測並不簡單,但是的確有一種可以超越單純推測,更加可靠的框架存在,即 Häggström 提出的 Omohundro-Bostrom theory of ultimate vs instrumental AI goals (Omohundro, 2008; Bostrom,2012, 2014) ,它建立在兩個基礎定理之上:正交論(the orthogonality thesis)和工具收斂論(theinstrumental convergence thesis)之上。

正交論(粗略地)指出,幾乎任何最終目標都可以與所有高級智能兼容。基於這個想法可以構建自指悖論(如讓你的 智力保持在一只生活在 2017 年的狗之下),但除此之外,它還包括你可以編寫任何目標功能讓你的 AI 嘗試進行優化。對 Omohundro-Bostrom 理論和 AI 未來學不熟悉的人通常並不認為像曲別針生產最大化這樣的狹隘目標本質上是愚蠢的,因為這表明超級智能 AI 不可能有這樣一個目標。但是這把智能與目標混為一談了:智能只不過是將世界指向特定目標的能力,無論這些目標是什么。曲別針生產最大化對我們來說似乎很愚蠢,但這不是因為它本質上是愚蠢的,而是因為它與我們的目標相悖。

接下來是工具收斂論。人工智能可能會採用各種工具目標,作為促進其達成最終目標的工具。工具收斂論指出,在廣泛的目標范圍內,人工智能預計會採用很多工具性目標,其中一些是:

自我保護(不要讓他們拉掉你的電源插頭!),

獲取硬件和其他資源,

改進自己的軟件和硬件,

保留最終目標,並且

如果最終目標不符合人的價值觀,那么保持低調(隱藏你的目標和 / 或你的能力),直到你可以輕松戰勝所有的人。

當我提出這個理論時,立刻遭到了 Pinker 的反對,他說道:

如果我們給機器設定了自我保護的目標,它會採取任何行動包括幹掉我們來保護自己... 避免這種情況的方法就是不要創造這種愚蠢的系統! (STOA, 2017,11:57:45)

然而,他沒弄明白我的意思,那就是 Omohundro-Bostrom 讓我們相信,足夠高級的智能更傾向於採用工具性目標中的自我保護,而不管是不是人類程序員下的命令。

4. 制定人工智能憲章

我們應該提高目前政治力量實施規則的敏捷性、效率和系統性,發展更加正式和制度化的民主程序,甚至是新的政治模式。

——Thomas Metzinger

現在是時候將關於 AI 的討論從大眾推向政府機構層面了。許多專家認為,我們正面臨著未來幾十年的一個曆史轉折點,關於人工智能的應用道德也迎來了一個曆史節點。因此,政府機構應該為了 AI 的健康發展制定相應的政策和限制。他們還必須創造出一個理性的,以證據為基礎的批判性討論過程,旨在不斷更新、改進和修訂最早的規范性約束。鑒於目前的情況,我們默認極少數人、大型私企和軍事機構是 AI 發展相關規則的制定者。因此,我們的目標就是積極整合盡可能多的來自社會各方的意見,並及時做出回應。

世界各地已經採取了許多不同的舉措,並且正在近期積極開展涉及人工智能應用倫理、法律、未來社會文化、存在風險和決策等方面的調查。公眾對 AI 的討論激烈,甚至給人一種歐盟這樣主要政治機構無法對 AI 的最新進展和風險等問題做出及時反應的印象。因此,我們應該提高目前政治力量實施規則的敏捷性、效率和系統性,發展更加正式和制度化的民主程序,甚至是新的政治模式。

我列出了五個面臨著 AI 挑戰的最重要的領域並給出了我的建議,先從歐盟(EU)開始講起。

“逐底競爭”問題

我們需要建立一個全球級的 AI 研究安全標准。我們需要一個全球性的 AI 憲章,因為只有全球范圍內所有參與或投資 AI 研究的國家之間達成了協議,這樣的安全標准才會發揮效用。鑒於目前的經濟和軍事力量發展水平,AI 研究很可能會向安全標准更低、政治透明度較低的國家和地區轉移。如果能夠達成國際間合作,那么就可以避免安全標准的“逐底競爭”(通過重置 AI 科學和產業研究機構的位置)。然而,考慮到現狀,這個問題很難解決。

建議 1:歐盟應立即制定歐洲人工智能憲章。

建議 2:與此同時,歐盟應該制定引導全球人工智能憲章的政治程序。

建議 3:歐盟應該投入資源以系統地加強國際合作和協調。應該盡量減少戰略上的不信任,並可以通過最廣泛的消極情景定義國家間的共同點。

第二個需要研究的領域可以說是由最緊迫的一系列問題構成的,而且被充分解決的幾率也很小。

避免 AI 軍備競賽

預防 AI 軍備競賽將比禁止核武器擴散的任務更艱難,更複雜,因為相關的研究不會只在大學校園裏進行。而且,如果人類一旦開始 AI 軍備競賽,這種競賽可能會是自動化的,到時候政治幹預已經無能為力了。

建議 4:歐盟應該禁止在其領土開展任何關於攻擊性自主武器的研究,並尋求達成國際協議。

建議 5:對於純粹的防禦性軍事應用,歐盟應該給予符合人類道德和法律的 AI 研究最大程度的支持。

建議 6:在國際上,歐盟應該使用所有可用的外交和政治手段採取一項重大舉措防止人工智能武器的出現。

第三個問題領域離我們還有相當遙遠,但是認知不確定性很高且潛在的風險可能非常大。

終止意識現象

Synthetic phenomenology 是“synthetic biology”的類比,指不僅創造出一般的智能,而且高級人工智能擁有了意識和自我感覺。而在現有的政治程序中不存在關於人工智能的規定,它們沒有法律地位,利益也沒有任何保障。為了做出符合道德的決定,了解哪些自然和人工系統可以產生意識、擁有感覺是非常重要的。

建議 7:歐盟應該禁止在其領土上旨在或導致意識現象的所有研究,並尋求達成國際協議。

建議 8:鑒於目前機器意識的不確定性和各方不同意見,迫切需要促進、資助和協調有關的跨學科研究項目(包括哲學、神經科學和計算機科學)。具體的相關課題包括有證據表明的意識、神經生物學和計算模型、自我意識和痛苦等。

建議 9:在基礎研究的層面上,需要促進、資助和協調關於具有意識體驗、自我意識和痛苦的非生物系統應用倫理的系統研究。

對社會凝聚力的威脅

我們無法保證未來不會出現我們現階段意識不到的、AI 可能帶來的威脅,因此,歐盟應該分配專門的資源,以應對將來可能出現的“未知的未知”。

除了大多數人能夠意識到的失業、社會階級化更嚴重等問題,AI 還會帶來其他破壞社會凝聚力、產生社會不安定的因素,如私有企業自動化控制社交媒體以吸引公眾眼球,或對信息進行加工影響政治走向。未來的 AI 技術將更加擅長對人類行為進行建模和預測,並可能會引起全球性風險。因此,應該小心對待任何 AI 的獎勵功能,以確定其不會對大眾造成直接或間接的傷害。

AI 目前只對一些私企利好,因此民主政治機構有責任投入資源,建立合理的機制,讓其普惠大眾,惠及全人類。

建議 10:在歐盟內部,人工智能相關的生產力收益必須以公正的方式分配。然而很明顯,我們過去沒做到這一點,而且現存的經濟制度也與這一建議相悖。

建議 11:歐盟應該仔細研究實行無條件基本收入或消極收入稅政策。

建議 12:研究項目需要把針對受 AI 影響的人口進行定時技能和社會技巧再培訓的計劃提上日程。

道德研究

關於 AI 的一個非常難以定義的理論問題,是在什么條件下應該決定放棄某項研究,終止一個研究項目的具體條件和場景是什么?在一個集體決定並不現實和最有效,需要建立一個非全球專門合作的場景下,機構會如何處理不道德的行為?因此,歐盟應該在 AI 憲章中明文列明研究者應該在項目中應該遵守的道德准則。

當然,更加進一步的目標是研究社區本身應自覺形成一種對道德敏感的文化,理性、基於證據的研究和控制風險最小化應該成為研究項目的一部分,因為他們是處於最新發現的最前沿,對風險的了解最多,他們有責任為公眾安全做出努力。

建議 13:任何人工智能全球憲章,都應始終輔之以具體的道德行為守則,以指導研究人員進行日常工作。

建議 14:我們需要培養新一代精通 AI 技術、自動化系統問題應用的倫理專家。歐盟應該有系統地立即向相關的政治機構投資,以培養未來需要的專業人才,而且要達到學術上的卓越性和專業性。

元治理和不斷擴大的鴻溝

另一個如今出現的問題是:現有的管理機構不足以應對新出現的挑戰;政府監督已經遠遠落後於科技創新。

在我看來,現有的管理結構正是這一問題的一部分:為了填補,至少是縮小不斷擴大的鴻溝,我們必須投入資源改變現有的管理機構。

“元治理”是指某一科技領域因為爆炸性增長而面臨治理上的風險和潛在的利益,管理這種治理風險的管理政策。例如,Wendell Wallach 曾指出,新興技術的有效監督需要政府機構強制執行和擴大的軟治理機制兩者相結合。

因此,Marchant 和 Wallach 提出了所謂的“治理協調委員會”(GCC,Governance Coordination Committees)。這是一種新型機構,用現有的政治機構協調和同步“治理戰略、行動、建議和機構的爆炸式增長”。AI 的 GCC 可以作為迅速興起的技術的“問題管理者”、信息交換所、預警系統和分析監測工具、國際最佳實踐評估員,並且還是一個倫理學家、媒體、科學家和利益相關者可以信賴的獨立機構。正如 Marchant 和 Wallach所說:“GCC 發揮的作用取決於其能夠扮演一個合格的經紀人角色”。

建議 15:歐盟應該大力投資於研究和開發新的管理結構,提高現有政治機構對問題的反應速度,以及制定新的規則。

說到底,大家對於人類是否應該畏懼 AI 還是爭執不下。但就像前文所說,我們永遠無法預測“未知的未知”,高級人工智能將在未來扮演什么樣的角色,是否會在某一天突然對自己在這個系統中的地位不滿而“奮起反抗”全都是未知,我們需要對這個問題保有討論的空間。

根據新華社、人民網、創業邦、經濟日報等採編【版權所有,文章觀點不代表華發網官方立場】

上一篇:區塊鏈可以提高銀行業的信用

下一篇:中國首艘國產航母“動身”

- 凡本網註明"来源:華發網繁體版的所有作品,版權均屬於華發網繁體版,轉載請必須註明來自華發網繁體版,https://china168.org。違反者本網將追究相關法律責任。

- 本網轉載並註明自其它來源的作品,目的在於傳遞更多信息,並不代表本網贊同其觀點或證實其內容的真實性,不承擔此類作品侵權行為的直接責任及連帶責任。其他媒體、網站或個人從本網轉載時,必須保留本網註明的作品來源,並自負版權等法律責任。

- 如涉及作品內容、版權等問題,請在作品發表之日起一周內與本網聯系,否則視為放棄相關權利。

- 中國創新研發2.4萬億 穩居全球第二

- 諾貝爾物理學獎頒予3科學家 表揚對理解複雜物理系統貢獻

- 航天員明與港青「天地對話」 楊潤雄冀學校安排同學觀看直播

- 29歲女博士5天被騙85萬: 孩子, 我寧愿你少讀點書

- 解放軍空中突擊旅可一小時包圍台灣“總統府”

- 1演習後發現榴彈短少 台軍全面清查

據中通社報道:台軍「漢光演習」結束後,陸軍第八軍團下轄裝甲旅日前清點彈藥時,發現40毫米榴彈練習彈數量與清冊不符。軍方22日回應,已成立專案小組清查中,並將檢討究責,防範類似事件重演。 [詳細]

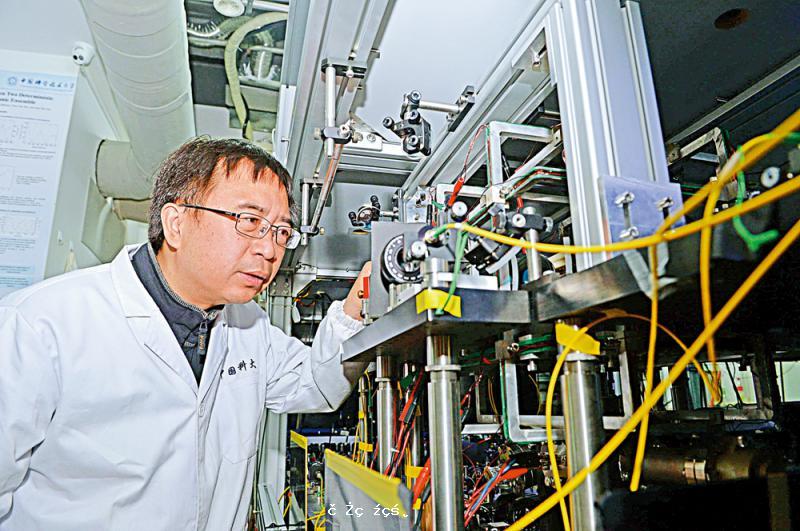

- 2「九章」量子神算 秒解億年難題

記者4日從中國科學技術大學獲悉,該校潘建偉、陸朝陽等組成的研究團隊與中科院上海微系統所、國家並行計算機工程技術研究中心合作,構建了76個光子的量子計算原型機(港稱量子電腦原型機)「九章」,求解數學算法高斯玻色取樣只需200秒,而目前世界最快的超級[詳細]

- 3 哪些核心技術, 還在“卡脖子”?

劉亞東認為,缺乏科學武裝、缺乏工匠精神、缺乏持之以恆的情懷,成為阻礙中國攻克一些核心技術的共性原因。 “我國科技創新已進入跟跑、並跑、領跑‘三跑並存’的新階段。其中,2016年,全國投入研究與試驗發展經費15676.7億元,超過歐盟15國的平均水準2.0[詳細]

- 4軍售化整為零 美賣台36戰車

據外媒報道,美國國防部證實,將出售36輛AAV7A1型兩棲突擊車,這項總額為8360萬美元(約6.55億港元)的訂單由英國航太系統公司負責,預計2020年7月完成。兩岸學者表示,華府以小規模的個案方式處理軍售,是想降低中國大陸的強烈反應,但對台軍售違背中美三個聯[詳細]

- 5穗智能機器人產業達600億

據報道,記者7月1日從中國計算機學會廣州青年計算機科技論壇十五周年暨「智勝未來、智造廣州」專題論壇獲悉,目前廣州智能裝備及機器人產業規模已近500億元人民幣(約為593億港元),機器人生產量居全國第二。而廣州亦正在建設「國際科技產業創新中心」,打造[詳細]

- 6科大校友研平價潛拍機 透視海底

海洋世界深不見底,吸引不少海洋愛好者去潛去拍去發現,但市面上的潛拍機價格高達八萬元且大多作工業用途。香港科技大學碩士校友組成的團隊研發出主打大眾市場的潛拍機,售價只是1.6萬港元,可深潛水底五十米,電池續航達四小時。[詳細]

- 7「鵲橋」中繼星順利進入地月軌道

據新華社報道:5月21日,探月工程嫦娥四號任務「鵲橋」中繼星在西昌衛星發射中心發射升空。14日11時06分,「鵲橋」中繼星成功進入環繞距月球約6.5萬公里的Halo使命軌道。這是世界首顆運行於地月L2點的通信衛星,將為2018年底人類首次窺探月背而發射的嫦娥四號[詳細]

- 85G到來將催生更多智慧生活應用場景

作為全球最大的移動互聯網市場,中國預計將在2025年將成為全球最大的5G市場。24日舉辦的粵港澳大灣區金融科技發展高峰論壇暨第七屆港股100強頒獎典禮上,眾多嘉賓看好5G商用市場,認為5G的到來將催生更多智慧生活的應用場景。 [詳細]

- 9貝索斯送人上太空 旅費156萬起

據英國路透社報道:亞馬遜(Amazon)兼太空探索公司藍色起源(Blue Origin)創辦人貝索斯2019年擬實行首次送人上太空的計劃,據兩位知情人士透露,該火箭公司計劃向乘客收取約20萬至30萬美元(約156萬至234萬港元)的太空旅費。[詳細]

- 10機場App升呢 行李拎得即知

■林天福(右)介紹流動自助登機櫃位iCUSS。 香港文匯報記者莫雪芝 攝新功能程式下月有售可多次重用 不必一過關撲去輸送帶苦等機場智能化已是大勢所趨,在香港機場行李輸送帶苦候行李抵達一直為旅客所詬病。為提升旅客[詳細]

- 11C919大型客機第三架機首飛成功

28日,記者從商飛公司獲悉,當日12時45分,C919大型客機103架機平安降落上海浦東國際機場,圓滿完成第一次飛行,標誌着目前共三架C919飛機進入試飛狀態。 [詳細]

- 12中國首艘載人潛水器支持母船下水

據新華社報道:中船重工武船集團為中國大洋礦產資源研究開發協會打造「深海一號」8日在武漢順利下水。這是中國自主研製的第一艘載人潛水器支持母船,為中國大洋調查再添一利器。[詳細]

- 和氣生財6/李家超:推廣禮貌服務 提升香港魅力

- 行政長官李家超將赴北京述職

- 吸引力足/寧德時代來港落戶 設國際總部及研發中心

- 免簽生效 到中國經商旅遊更方便

- 特區政府斥美打「法案牌」干預港事務

- 高鐵載客量超越疫前 短途增幅大

- 民進黨處心積慮搞「台獨教育」

- 市區「輕微僭建」 研申報後暫緩執法

- 情牽兩岸/創業台青深耕國漫IP 傳播中華文化

- 施政報告前瞻/設中醫藥專員 建數碼化中藥平台

- 兩岸京劇一脈傳 好戲連「台」見情深

- 投資信心提振 恒指連升六日共千點